Entenda como a Inteligência Artificial pode frear a transição energética

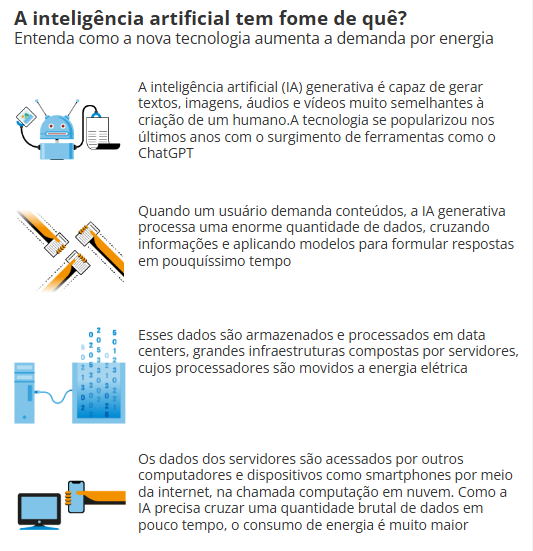

O avanço de ferramentas de inteligência artificial (IA), que serão cada vez mais utilizadas no dia a dia das pessoas e dos negócios, levanta preocupações devido ao seu impacto ambiental. Quem digita uma pergunta para um robô virtual turbinado pela IA generativa como o ChatGPT não pensa em quanta energia essa operação envolve.

Mas uma série de estudos tem mostrado que o consumo de energia desses sistemas para processar um volume enorme de dados em pouco tempo é tão significativo que já pode ser visto como mais um obstáculo para a redução das emissões de carbono para combater as mudanças climáticas.

Além disso, a nova tecnologia também demanda recursos escassos como água para resfriar equipamentos e matérias-primas para a indústria de chips.

Um relatório da Agência Internacional de Energia (AIE) do início deste ano estimou que o consumo de energia em centros de processamento de dados no mundo, que foi de 460 terawatt-hora (TWh) em 2022, pode chegar a 1.050 TWh em 2026 com o avanço da IA.

Isso equivale ao dobro da energia que o Brasil consome em um ano, cerca de 500 TWh. O cenário mais provável, segundo a agência, é uma demanda de 800 TWh, pouco menos que duas vezes a anual da França.

Mesmo assim, é como se o consumo de um Brasil e meio fosse utilizado apenas pelos data centers, que estão em expansão em várias partes do mundo para dar conta da nova demanda de processamento em alta velocidade da IA. Também entra nessa conta a mineração de criptomoedas.

Alerta similar veio da Ação Climática Contra a Desinformação, que reúne organizações de defesa do meio ambiente e pede mais transparência das empresas de tecnologia e regulação global do setor.

Emissão de gases

No mês passado, a questão foi abordada em um levantamento sobre a segurança da IA encomendado pelo governo britânico a um painel de especialistas liderado pelo canadense Yoshua Bengio, um dos pioneiros da IA. O texto diz que a nova tecnologia pode levar a um aumento das emissões de gases de efeito estufa, a depender das fontes de energia utilizadas.

Se já tem sido difícil descarbonizar a geração de energia, a demanda adicional da IA só torna esse objetivo mais distante, dizem os especialistas.

Isso também amplia o desafio das big techs em suas metas de neutralizar suas emissões. Até mesmo Sam Altman, o CEO da OpenAI, a criadora do ChatGPT, afirmou no início do ano que será necessário um grande avanço na produção de energia limpa para atender à demanda criada pela IA generativa.

Os modelos cruzam uma série de dados em pouco tempo para gerar seus conteúdos e demandam processadores cada vez mais avançados e que consomem mais energia. A AIE estimou, por exemplo, o impacto da integração da IA a ferramentas de busca, como está fazendo o Google.

Isso pode levar a um aumento de 10 TWh no consumo anual global de energia, suficiente para 3 milhões de casas nos EUA.

Em um artigo publicado no periódico científico Joule, e citado no relatório da AIE, o pesquisador Alex de Vries, da Universidade de Amsterdã, afirmou que, em um cenário extremo, apenas a IA do Google poderia consumir tanta eletricidade quanto a Irlanda, apesar de ressaltar que o mais provável é um impacto menor.

Ele avalia que pode ocorrer um aumento de eficiência das ferramentas de IA, diminuindo seu consumo de energia. Entretanto, alerta para o chamado Paradoxo de Jevons: a melhora na eficiência pode gerar maior uso, anulando os ganhos.

Em entrevista ao GLOBO, Vries observou que as empresas de tecnologia têm priorizado o crescimento e colocado a sustentabilidade em segundo plano. Ele ressalta que as emissões de carbono da Microsoft aumentaram 29,1% no ano passado, o que dificulta a meta da empresa de neutralizar sua pegada de carbono até 2030.

— As emissões estão aumentando, então eles estão priorizando o crescimento da IA, e deixaram para se preocupar com as emissões depois — ele avalia. — Sobre sustentabilidade, quanto menos energia consumirmos, melhor. Mas com a IA é o contrário: quanto maior, melhor. E modelos maiores exigem mais energia.

Para o sócio da PwC Brasil Adriano Correia, líder do setor de energia da consultoria, o aumento no consumo energético gerado pela IA é um “caminho sem volta”:

— Se quisermos ter uma capacidade de processamento de dados maior, vamos ter um impacto grande no consumo de energia. E se já temos hoje um desafio de gerar energia renovável suficiente para substituir os combustíveis fósseis, esse desafio cresce ainda mais.

Consumo de água

Correia ressalta outros dois impactos ambientais importantes da IA: o maior incentivo à mineração, para retirar metais raros utilizados na fabricação de equipamentos e componentes de data centers, e o do lixo eletrônico, que cresce junto com a obsolescência das tecnologias antigas.

Grandes grupos financeiros e as próprias big techs têm anunciado investimentos bilionários na ampliação e troca de equipamentos de data centers, que já vinham crescendo com a expansão da computação em nuvem, ou na construção de novos em todo o mundo, além de empreendimentos de geração de energia de fontes limpas, como solar, eólica e nuclear, para abastecer esses novos centros de processamento.

A KKR, que investe US$ 1 bilhão em data centers na Ásia, estima que a capacidade total desses centros no mundo vai triplicar em seis anos. O Google anunciou recentemente um aporte de US$ 2 bilhões em infraestrutura de processamento na Malásia, que dá incentivos fiscais para esse tipo de empreendimento.

O país asiático tem atraído projetos que iam para Cingapura, que chegou a suspender por três anos licenças para data centers por causa da restrição na oferta de energia e de terrenos. A Microsoft investe US$ 7,7 bilhões nesse tipo de projeto em Reino Unido, Japão e Indonésia, e seu cofundador Bill Gates aposta numa startup de pequenos reatores nucleares que podem abastecer data centers.

Chance para o Brasil

Esse cenário pode abrir oportunidades para o Brasil atrair alguns desses investimentos bilionários com sua grande oferta de fontes renováveis de energia, diz Correia, da PwC:

— Não vejo outros países com uma condição tão competitiva para atrair data center como a gente tem hoje aqui.

Shaolei Ren, professor de engenharia da computação na Universidade da Califórnia, nos EUA, afirma que os recursos hídricos também favorecem o Brasil nesse sentido. Ele é um dos autores de um estudo com pesquisadores do Texas, ainda não publicado, que estimou em 5,4 milhões de litros a água consumida pelo processamento necessário para treinar o ChatGPT-3 — o equivalente a duas piscinas olímpicas.

Para gerar entre dez e 50 respostas, o robô virtual da OpenAI demanda 500ml de água, a depender de onde estão os data centers. A estimativa foi feita a partir de um modelo antigo. Provavelmente é maior para sistemas mais atuais, como o ChatGPT-4, que têm maior capacidade de geração de conteúdo e, por isso, demandam mais recursos.

As ferramentas de IA demandam água na geração da energia que abastece data centers, no resfriamento dos equipamentos e na fabricação de chips e servidores. Os autores ressaltam que é possível adotar estratégias para diminuir o consumo de água dessa infraestrutura, variando o local e até mesmo o horário das atividades. Ren diz que a pegada de carbono da energia consumida pela IA ganha mais atenção, mas frisa que o uso de água não é menos importante.

Procuradas, as principais desenvolvedoras da IA dizem tomar medidas para reduzir o impacto ambiental. A Microsoft afirmou que o aumento em suas emissões de carbono foi indireto, decorrente da cadeia de produção, não de sua atividade principal, e que toma medidas para a redução, como exigir de fornecedores de grande escala o uso de energia limpa.

O Google diz que seus data centers têm eficiência energética de 1,5 vez a média do setor e que, em comparação com cinco anos atrás, tem quase três vezes mais poder computacional com o mesmo consumo de energia. A OpenAI não respondeu.

Matéria publicada pelo O Globo no dia 16/06/2024, às 04h00 (horário de Brasília)